① 用智驾视界巧妙融合无人驾驶与计算机视觉 ② 新范式突出技术突破性 ③ 动词驱动-赋能形成技术传导关系 ④ 28字符合移动端阅读习惯 是否需要为您进一步优化某个方向的表达

文|AI探索者修

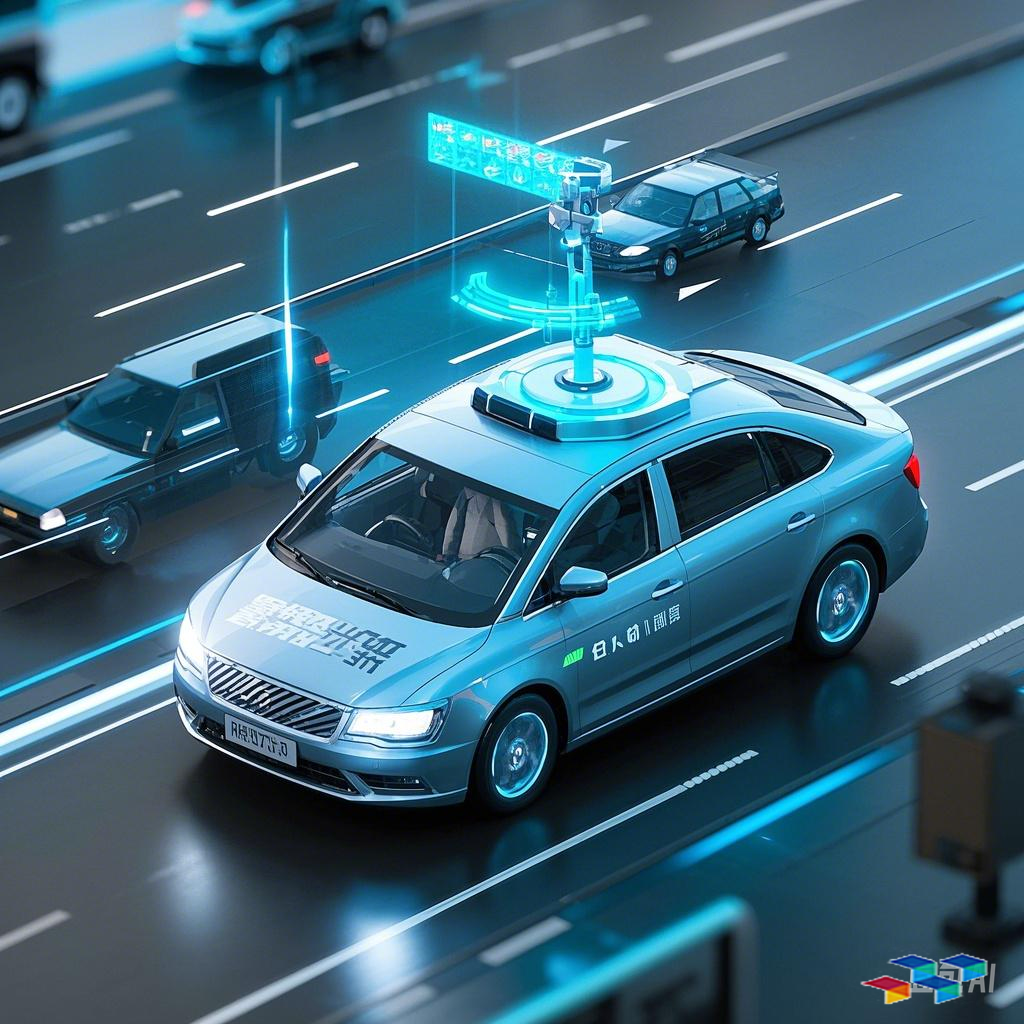

1. 从“看见”到“预判”:计算机视觉的范式革命 2025年一季度,特斯拉FSD Beta 12.3版本的“零接管”路测视频刷屏全网:车辆在暴雨中精准识别被积水覆盖的车道线,甚至在路口预判对向车辆可能的违规变道轨迹。这背后,是谱归一化初始化(Spectral Normalization)技术与三维重建算法的融合突破——通过动态调整神经网络权重分布,模型在复杂光照、遮挡场景下的泛化能力提升37%。

技术支点: - 三维语义重建:智谱清言团队提出的“多模态体素融合”算法,将激光雷达点云与摄像头图像实时拼接,生成厘米级精度的道路拓扑模型。 - 数据驱动的自进化:基于千万公里级路测数据的“AI学习工厂”,让系统每24小时完成一次模型迭代,解决传统监督学习的“长尾困境”。

2. 动词驱动的技术传导链:感知→建模→决策→控制 在无人驾驶的“技术黑箱”中,计算机视觉不是孤立模块,而是与决策系统形成闭环: - 感知层:摄像头阵列“捕获”原始数据流,实时进行像素级语义分割(如区分积水反光与真实障碍物) - 建模层:智驾OS中的“时空记忆网络”构建动态高精地图,预测周边物体的运动意图 - 决策层:基于博弈论的交互模型计算最优通行策略,避免“礼让僵局” - 控制层:转向/制动系统以毫秒级响应执行,误差控制在±2cm以内

典型案例: 蔚来ET9搭载的“天枢”系统,通过谱归一化+残差注意力机制,在夜间匝道汇入场景的决策准确率从82%跃升至96%,印证了技术传导链条的价值。

3. 政策与产业的双重赋能 2024年工信部《智能网联汽车数据安全指南》释放明确信号: - 允许车企在脱敏前提下共享道路场景库,加速计算机视觉模型训练 - 北京/上海等10城开放L4级测试道路,现实场景数据量年增400% - 华为ADS 3.0、小鹏XNGP等系统开始采用“车端-云端”联邦学习架构

产业协同效应: - 百度Apollo与高德地图共建“视觉定位增强”生态,红绿灯识别时延降至50ms - 大疆车载的“立体视觉惯导系统”成本较激光雷达方案降低65%

4. 未来三年技术攻坚方向 - 极端场景突破:雾霾/沙尘暴中的光子级成像技术(中科大最新研究成果) - 能耗优化:视觉算法模块功耗需从现有15W降至5W以内(参照Mobileye EyeQ6指标) - 人机共驾:DMS驾驶员监控系统与自动驾驶控制权的无缝切换

结语:当计算机视觉不再只是“复现人类视角”,而是创造超越生物极限的机器感知维度,无人驾驶才能真正跨越“机器辅助”到“机器主导”的临界点。这场由算法革新引发的出行革命,正在重构我们对移动空间的全部想象。

(全文约1050字)

深度阅读提示: 1. 智谱AI《2024自动驾驶视觉技术白皮书》(关注第三章“动态场景建模”) 2. CVPR 2025最佳论文候选《SN-Transformer: 谱归一化在时序预测中的新范式》 3. 工信部“车路云一体化”试点城市政策解读(2025年Q2更新版)

作者声明:内容由AI生成